神经网络和反向传播

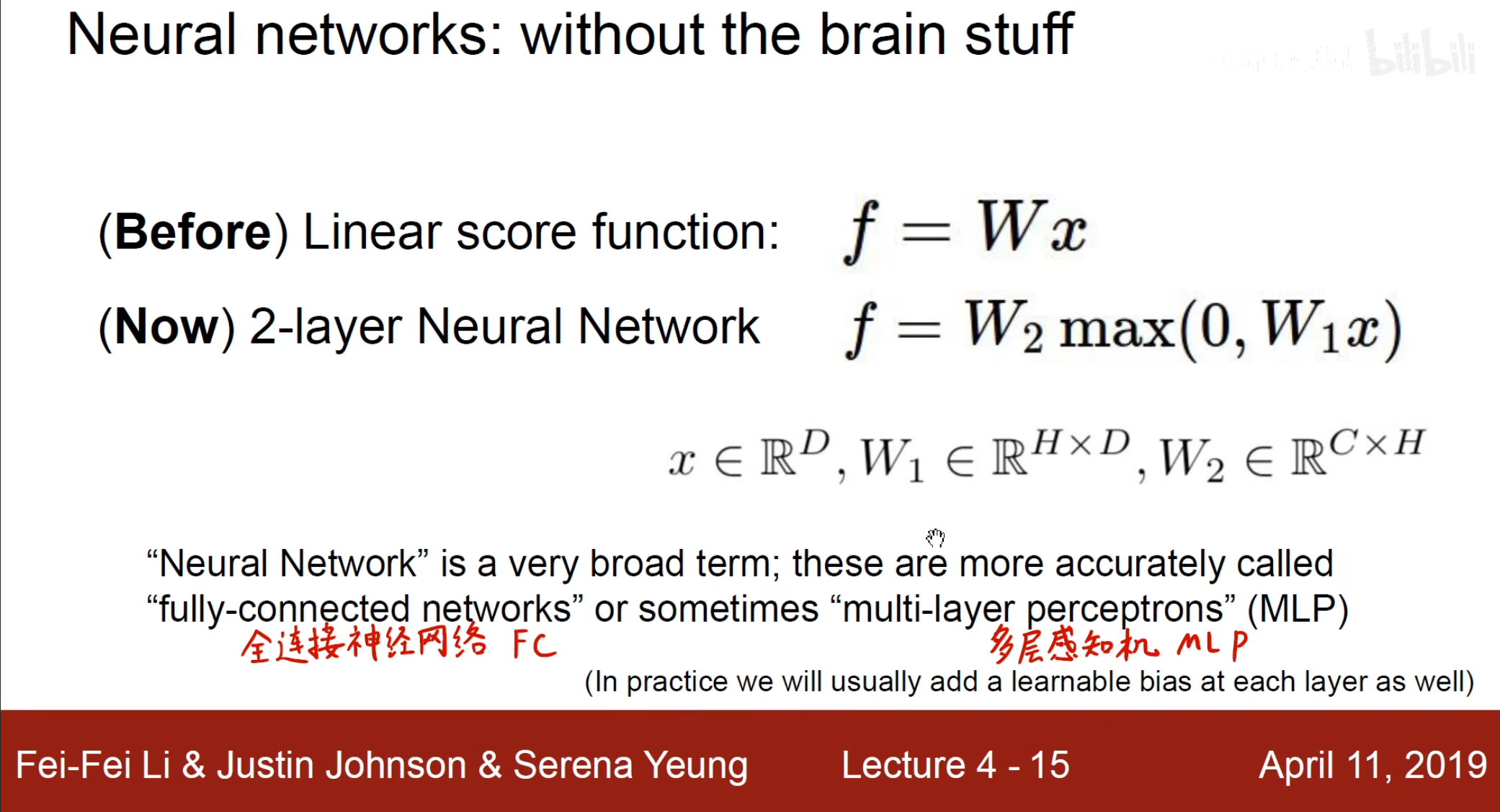

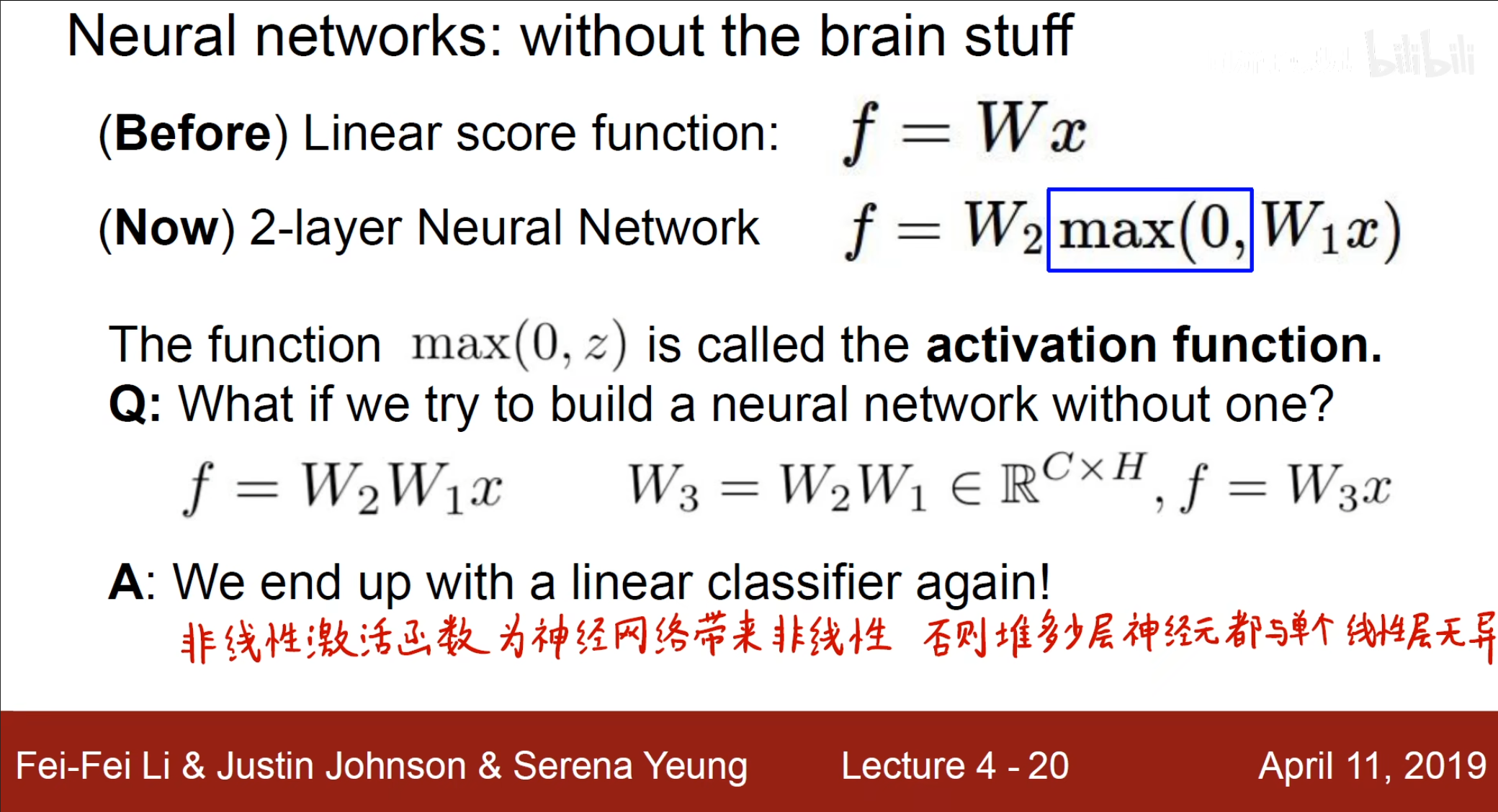

首先我们需要讲之前的线性函数转化为非线性函数,也就是使用$ Relu(x)=max(0,x) $这个激活函数,多个这样的感知机加在一起,也就是我们所讲的多层感知机$ MLP $,也被叫做全连接神经网络。

正是有了激活函数,神经网络才可以拟合非线性,否则无论有多少层神经元都可以使用一个线性转换得到最后的结果,和单个线性层无区别。

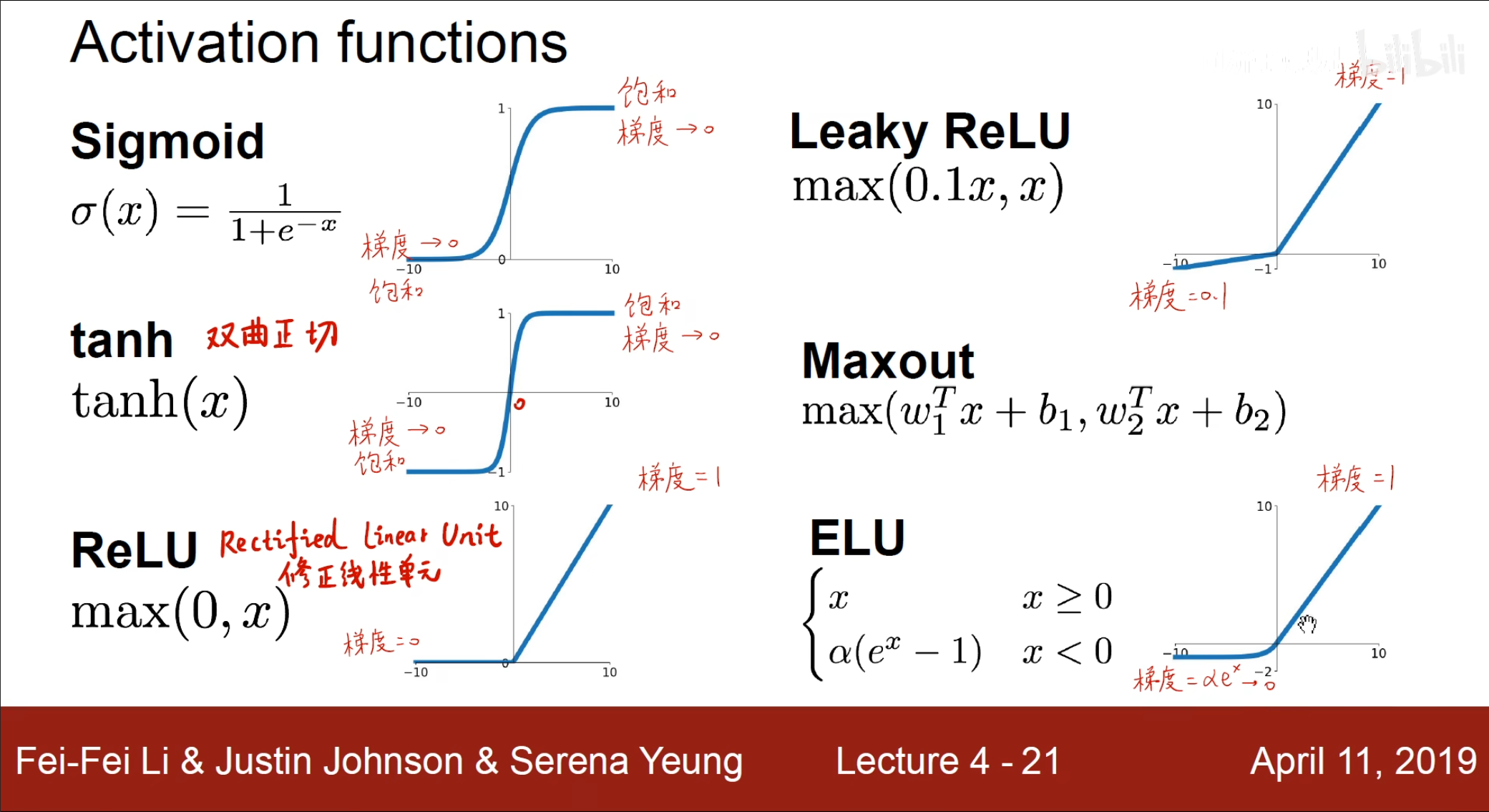

我们通常使用的有以下几种激活函数,其中$ ReLU $最为常用,因为其结构简单,但是由于在输入为负时的结果梯度为$ 0 $,因此有了$ ELU,Leaky ReLU $作为优化。

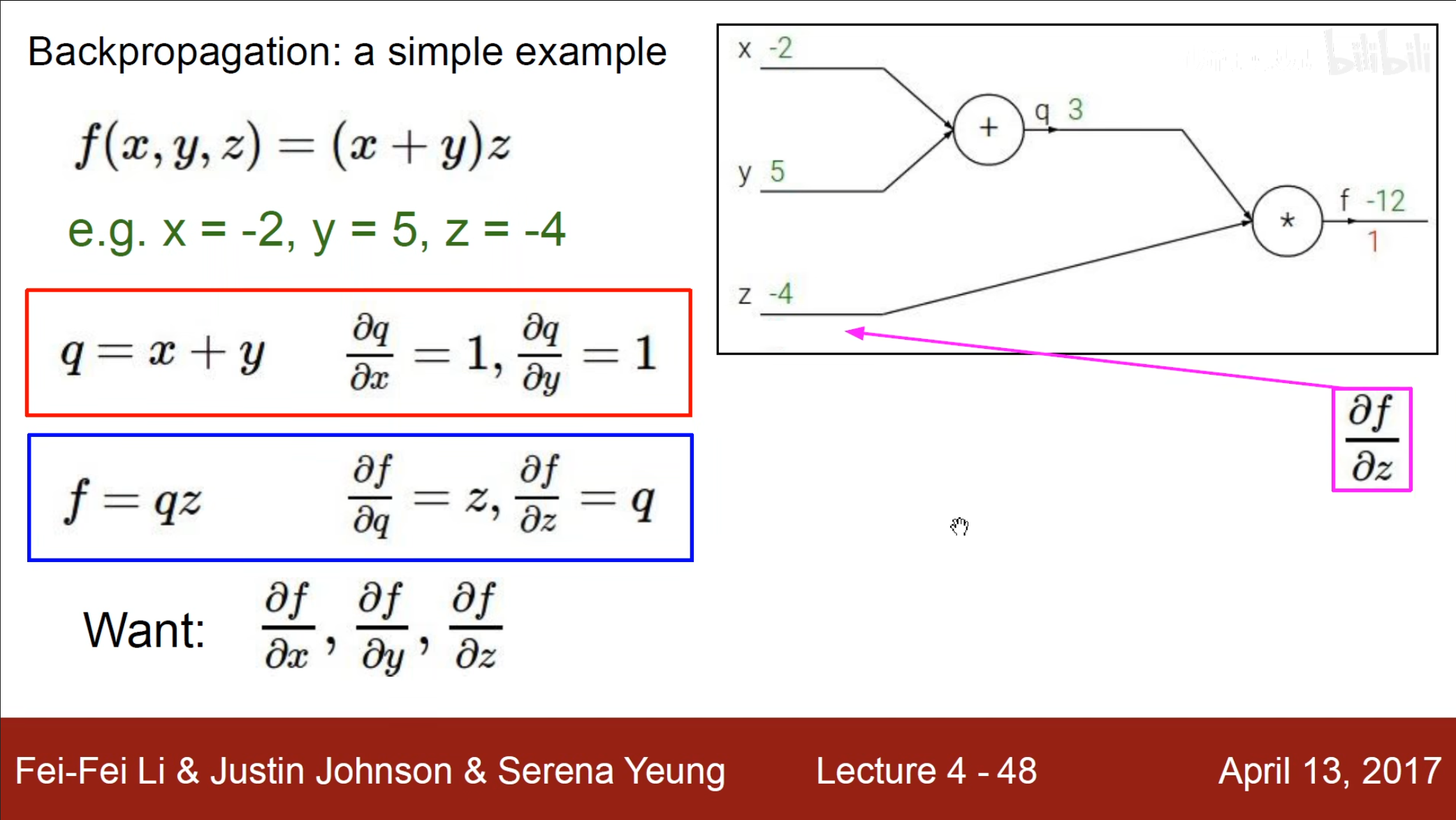

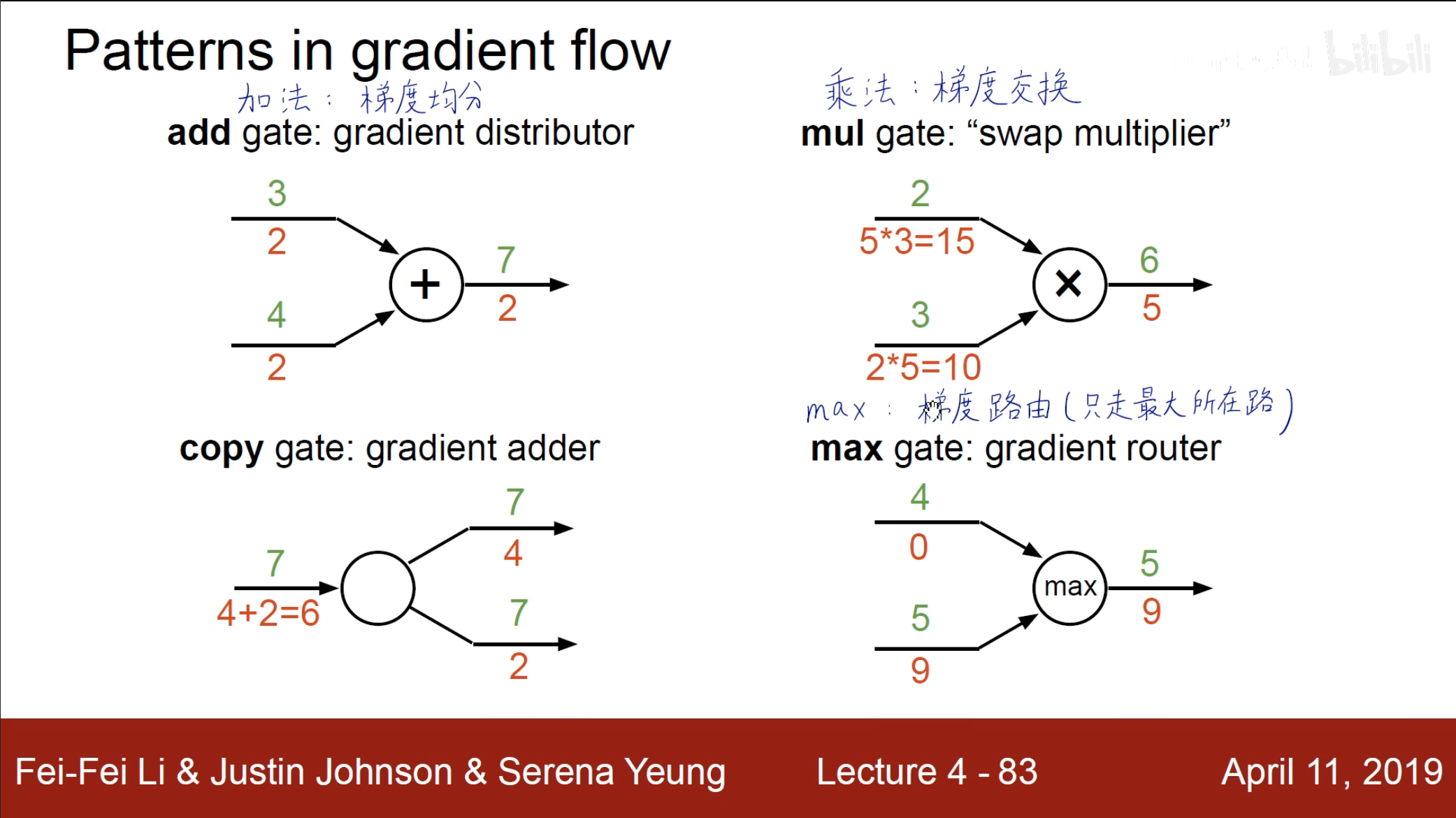

在计算梯度时,需要使用计算图和反向传播,这在机器学习中也有具体解释。

对于不同的操作,梯度的变换也不尽相同,例如,加法时梯度没有改变,乘法时梯度发生交换。

注意:隐含层的作用就是将输入的非线性的数据转换为线性可分的数据,因此在输出层中就不再需要使用激活函数。